官网 https://ollama.com/ | 详细使用描述 https://github.com/ollama/ollama

安装系统版本支持:macOS 、Windows、 Linux | 支持Docker (cpu和gpu)

关于模型的使用:应该至少有 8 GB 的内存来运行 7B 型号,16 GB 的内存来运行 13B 的型号,32 GB 的内存来运行 33B 型号

支持的模型列表 https://ollama.com/library

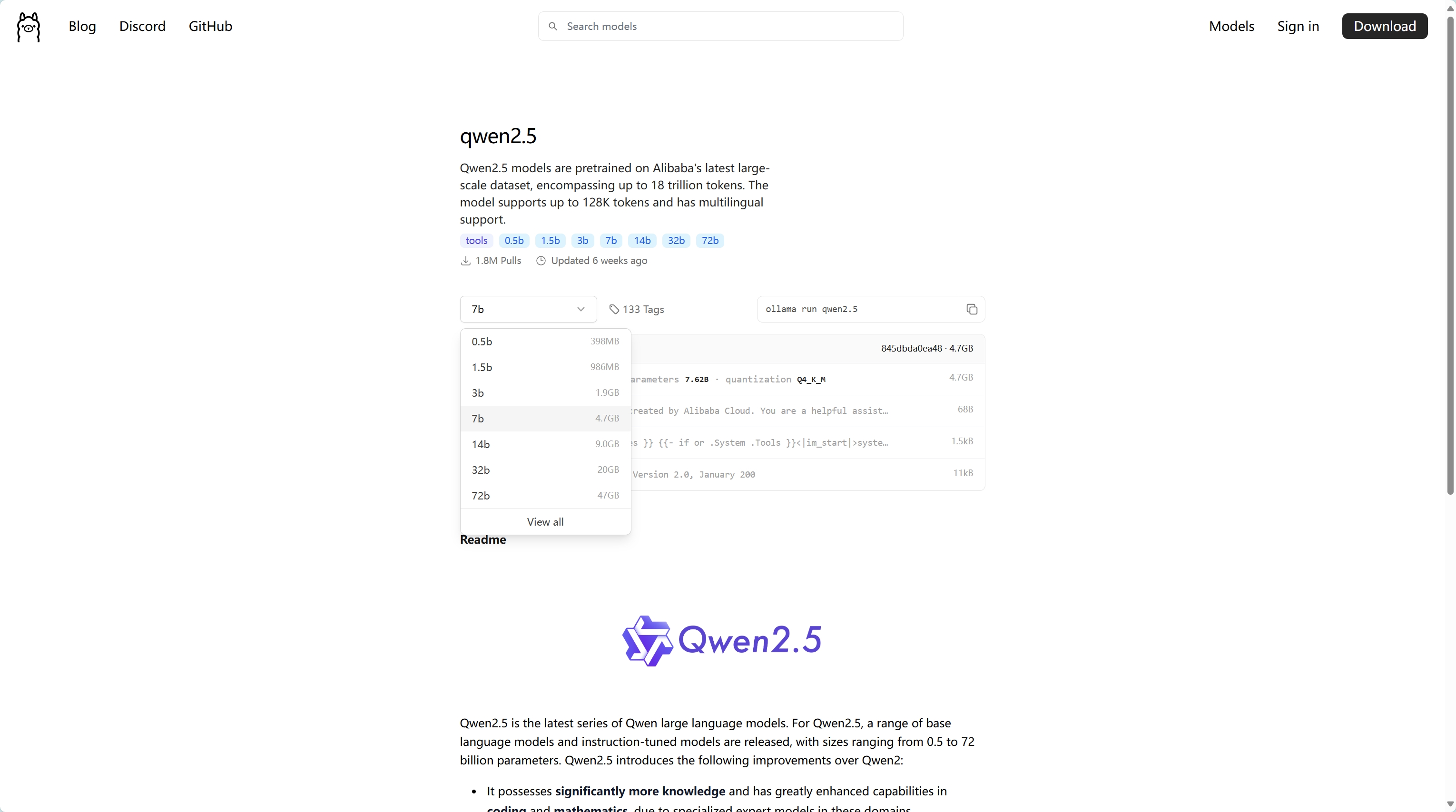

查看具体的模型,这里是查看千问2.5模型

ollama安装好后,配置几个系统变量(按需),window修改系统环境变量,linux修改全局系统变量

# 绑定的服务地址默认127.0.0.1,如果想让别人用你的ip可以调用就改成任意或者指定ip地址

OLLAMA_HOST=0.0.0.0

# 服务端口,默认11434,例如改为11111

OLLAMA_PORT=11111

# 模型下载的目录(写上你要把模型存放的目录绝对路径),例如windows下的D盘的ollama目录

OLLAMA_MODELS=D:\ollama

# 限制模型加载数量,可以根据你的系统性能调整,例如只能同时加载2个模型

OLLAMA_NUM_PARALLEL=2

# 限制在内存中同时存在的模型数量,防止内存溢出,例如只能存在1个模型在内存中

OLLAMA_MAX_LOADED_MODELS=1如何使用模型,服务启动后都是需要用命令去操作的

# 下载模型(例如,小内存机器下载一个千问2.5 1.5b 1G大小左右的模型),模型名称可以在官网模型页面点进去查看,下载速度很慢(除非用加速)

ollama pull qwen2.5:1.5b

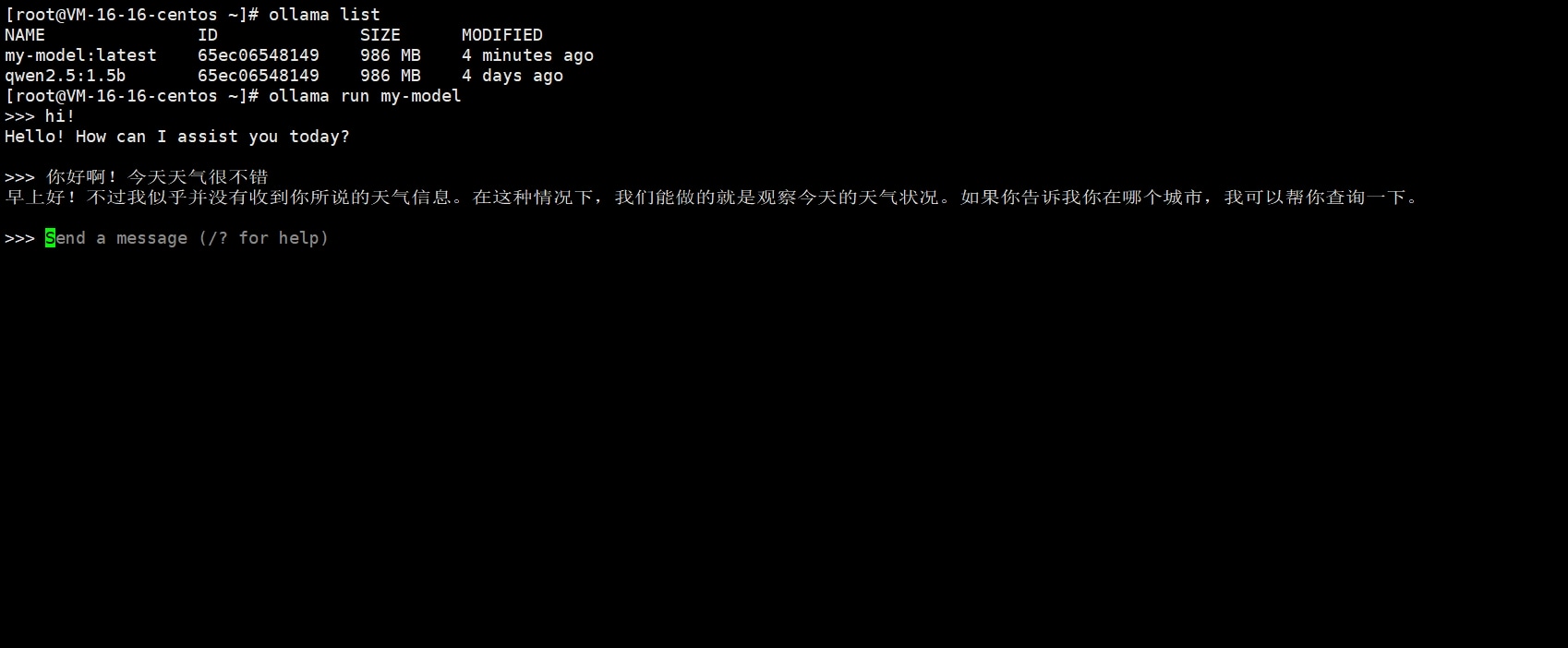

# 列出模型

ollama list

# 查看模型信息

ollama show qwen2.5:1.5b

# 删除模型

ollama rm qwen2.5:1.5b

# 复制模型

ollama cp qwen2.5:1.5b my-model

# 以命令行模式运行一个模型

ollama run qwen2.5:1.5b

# 列出当前运行中的模型

ollama ps

# 停止一个在运行模型(模型有新对话时还会再次运行起来)

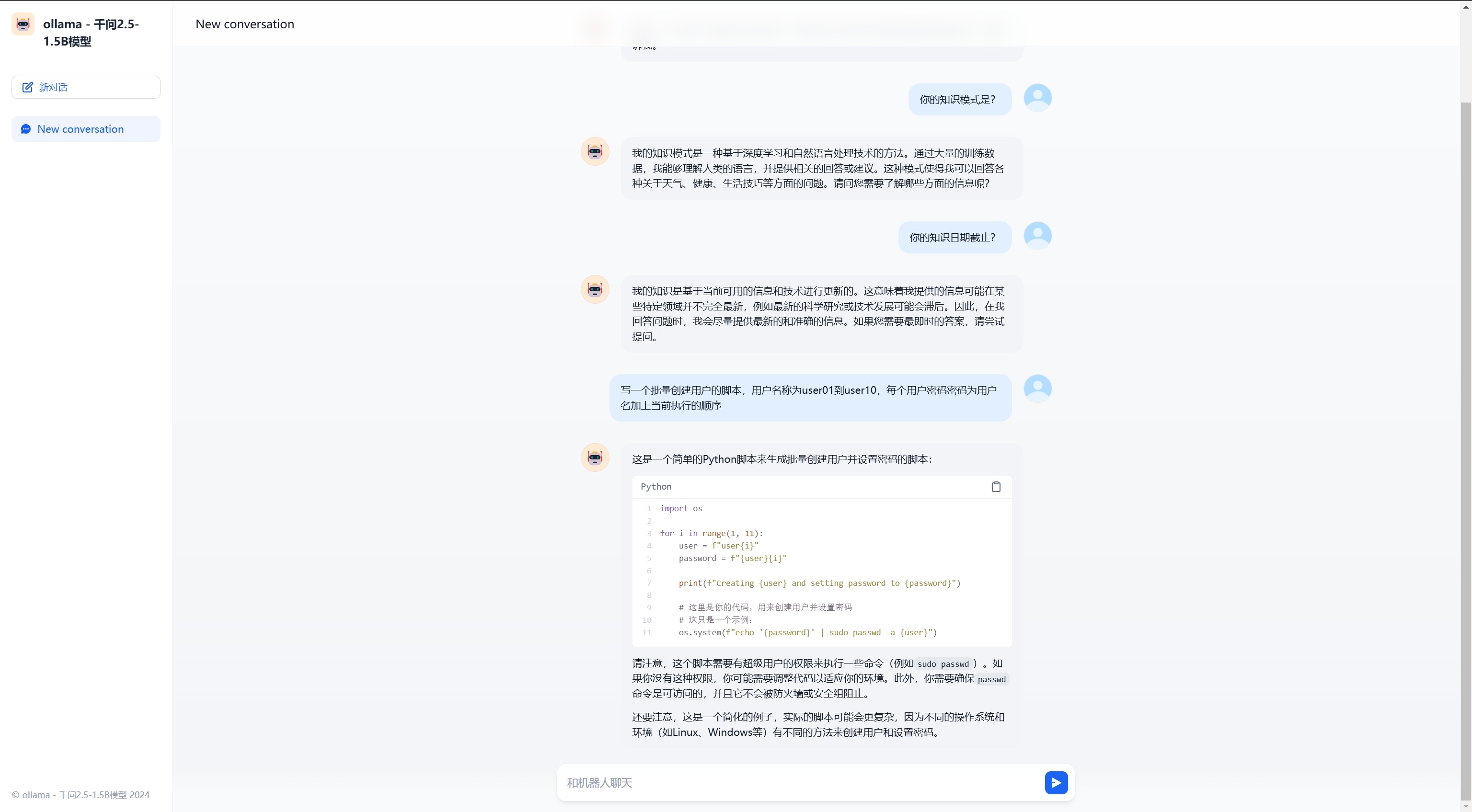

ollama stop qwen2.5:1.5b在命令行中运行一个小型对话语言模型

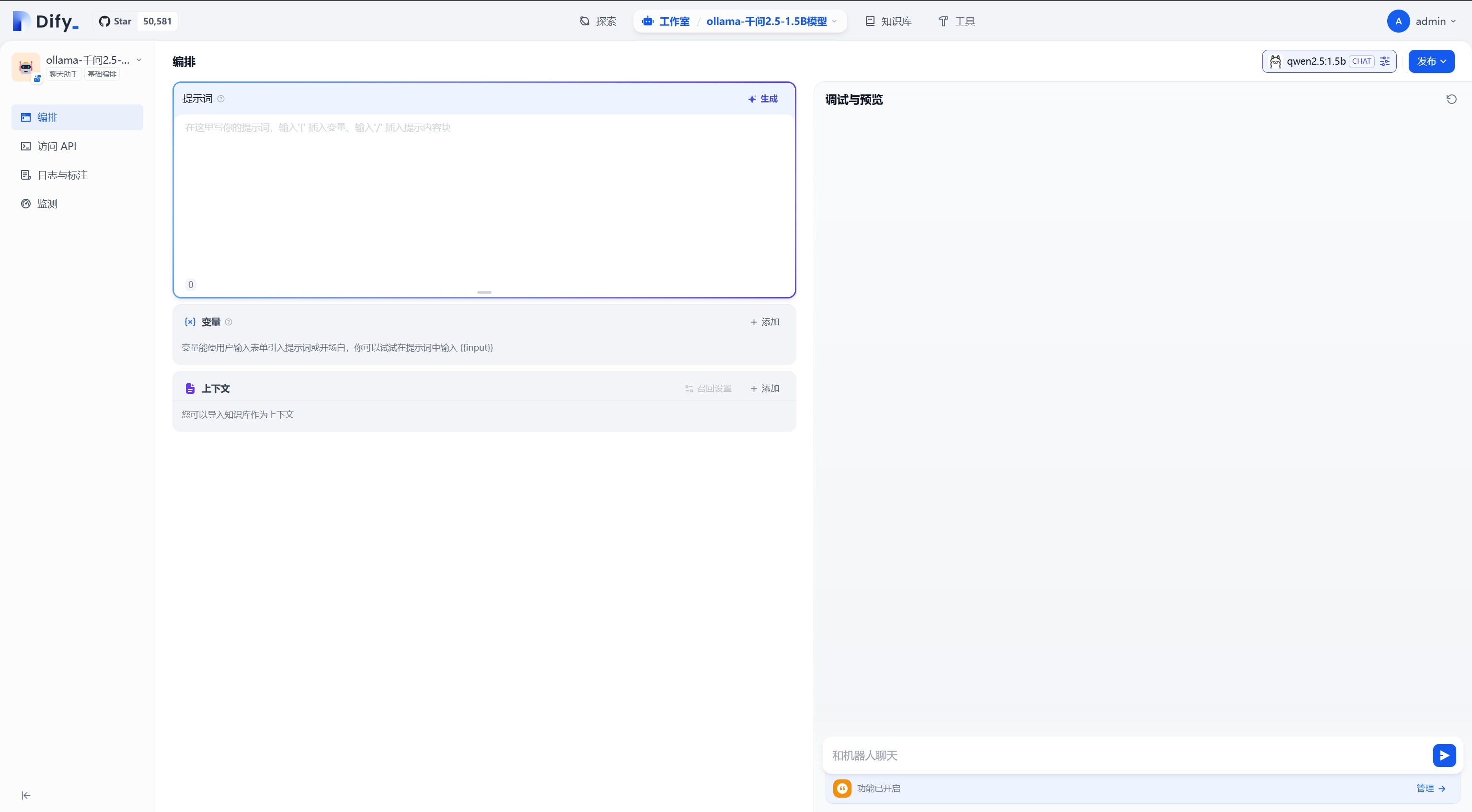

结合其他开源的可视化界面访问

本文最后记录时间 2025-03-25

文章链接地址:https://wojc.cn/archives/1588.html

本站文章除注明[转载|引用|来源|来自],均为本站原创内容,转载前请注明出处

文章链接地址:https://wojc.cn/archives/1588.html

本站文章除注明[转载|引用|来源|来自],均为本站原创内容,转载前请注明出处

留言